如何在linux远程服务器上直接下载huggingface官网的模型/数据集

Introduction:

在AI领域如nlp/cv等,做实验的时候经常会用到huggingface上各种开源的模型(数据集),同时也需要远程服务器(如实验室的服务器)的支持,才能有合适的算力并开展实验。如果将huggingface官网的模型一个个手动下载下来,并自己再用xftp等工具传到服务器上未免太烦太复杂。本人目前也是nlp方向的新入门的小白,方法也都是网上查来的,浅浅记录一下在远程服务器上下载huggingface的模型和数据集的全过程。下面直接进入正题。

Methodology:

具体使用的是huggingface-cli,属于huggingface_hub库,这是HuggingFace官方提供的命令行工具,属于官方工具,那各方面的肯定很完善

1 连接远程服务器,这个不用多说

2 安装huggingface_hub库

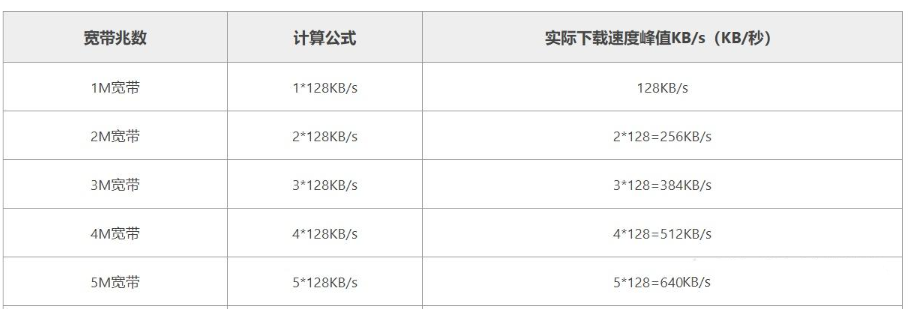

pip install -U huggingface_hub3 然后先设置国内镜像,否则下载时会出现“TimeoutError: [Errno 110] Connection timed out”的错误

# 配置环境变量

vim ~/.bashrc

# 在打开文件中的最后一行添加

export HF_ENDPOINT="https://hf-mirror.com"

# 使得更改生效

source ~/.bashrc4.1 下载模型,具体用法如下

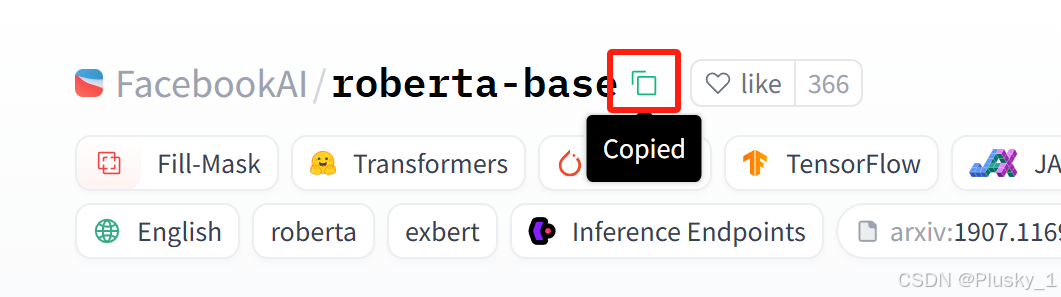

huggingface-cli download --resume-download {huggingface官网上的模型ID} --local-dir {想要下载到的目录}模型ID直接在网页上复制即可

比如说我想下载一个RoBERTa模型,那就像下面这样

huggingface-cli download --resume-download FacebookAI/roberta-base --local-dir ./roberta-base4.2 下载数据集,比下载模型多一个参数,具体用法如下

huggingface-cli download --repo-type dataset --resume-download {数据集ID} --local-dir {想放在本地哪里}想要下载数据集中的某个文件也是可以的,只需要在上一行命令中的数据集ID后面加上想下载的文件就行:

huggingface-cli download --repo-type dataset --resume-download {数据集ID} {单独下载的文件名称} --local-dir {想放在本地哪里}Conclusion:

完结撒花~